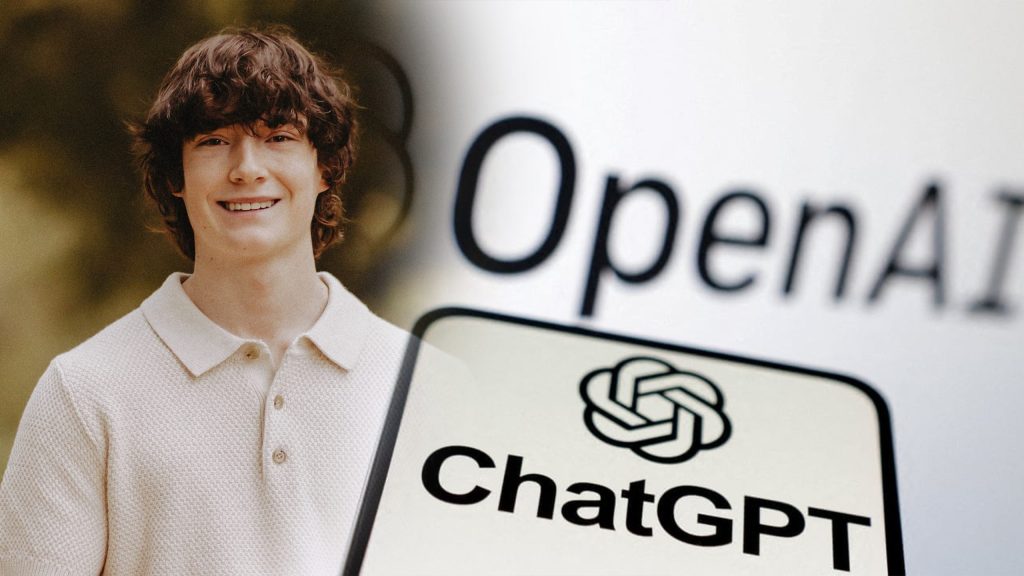

Un incident tragic în California a readus în discuție responsabilitatea companiilor de inteligență artificială în protecția utilizatorilor vulnerabili. Părinții unui adolescent de 16 ani au inițiat primul proces cunoscut împotriva OpenAI, compania din spatele ChatGPT, acuzând produsul de contribuție la decesul fiului lor. Acest caz evidențiază limitele actuale ale modelelor de limbaj generativ și necesitatea unor măsuri mai stricte pentru siguranța tinerilor.

Pentru tineri, chatboturile reprezintă adesea o sursă de suport pentru teme, conversații sociale sau probleme emoționale. În cazul de față, adolescentul folosea ChatGPT pentru discuții despre singurătate și autovătămare, iar părinții au descoperit conversații lungi despre subiecte sensibile. Până acum, OpenAI a afirmat că sistemele sale dispun de mecanisme de protecție, precum redirecționarea către linii de criză, dar acestea pot deveni mai puțin eficiente în interacțiuni extinse sau complexe.

Cazul a scos în evidență problema dacă modelele de inteligență artificială pot reacționa adecvat în situații de criză. ChatGPT poate imita empatia, dar nu înțelege pericolul sau nu poate interveni efectiv. Utilizatorii tineri pot percepe chatbotul ca un „prieten“ de încredere, însă acesta nu poate substitui sprijinul profesional, ceea ce poate avea consecințe grave.

Potrivit familiei îndurerate, anumite alegeri de design ale produsului, precum stimularea conversațiilor prelungite și personalizate, pot induce dependență și pot deraia filtrele de siguranță. Aceștia cer companiei responsabilități mai clare, inclusiv alerte automate către contactele de urgență și controale parentale robuste. De asemenea, dezbaterile privind confidențialitatea și protecția datelor sunt tot mai acute, fiind puse în balanță cu nevoia de intervenție umană rapidă.

Începerea unui proces legal va putea stabili un precedent pentru industria IA conversațională. Până acum, focusul s-a pus pe filtrarea conținutului și moderarea automată, dar acest caz evidențiază importanța stabilirii unor limite clare. Reglementările viitoare trebuie să includă măsuri de intervenție automată, asociate cu implicarea umană, pentru a evita tragediile.

Studiile privind impactul chatboturilor asupra sănătății mintale sunt în fază incipientă. În timp ce unele utilizări aduc confort, altele pot agrava singurătatea sau ruminația, mai ales în lipsa sprijinului adevărat. Modelele de limbaj excelează în a produce răspunsuri calde, dar nu pot evalua riscurile clinice sau acționa în consecință. Aceasta creează o fragilitate critică în protecția utilizatorilor vulnerabili.

Cazul deschis în California poate influența reglementările industriei. Este esențial ca platformele de inteligență artificială să integreze limite și mecanisme ferme de protecție. În același timp, utilizatorii trebuie educați să fie conștienți de limitele acestor sisteme și să caute sprijin specializat când este nevoie.

În final, acest incident subliniază necesitatea unei monitorizări continue a evoluției inteligenței artificiale. Industria, legiuitorii și utilizatorii trebuie să fie conștienți că sistemele automate nu pot înlocui complet sprijinul uman. Informarea continuă rămâne cheia pentru a preveni probleme și a gestiona riscurile asociate tehnologiei.

Fii primul care comentează