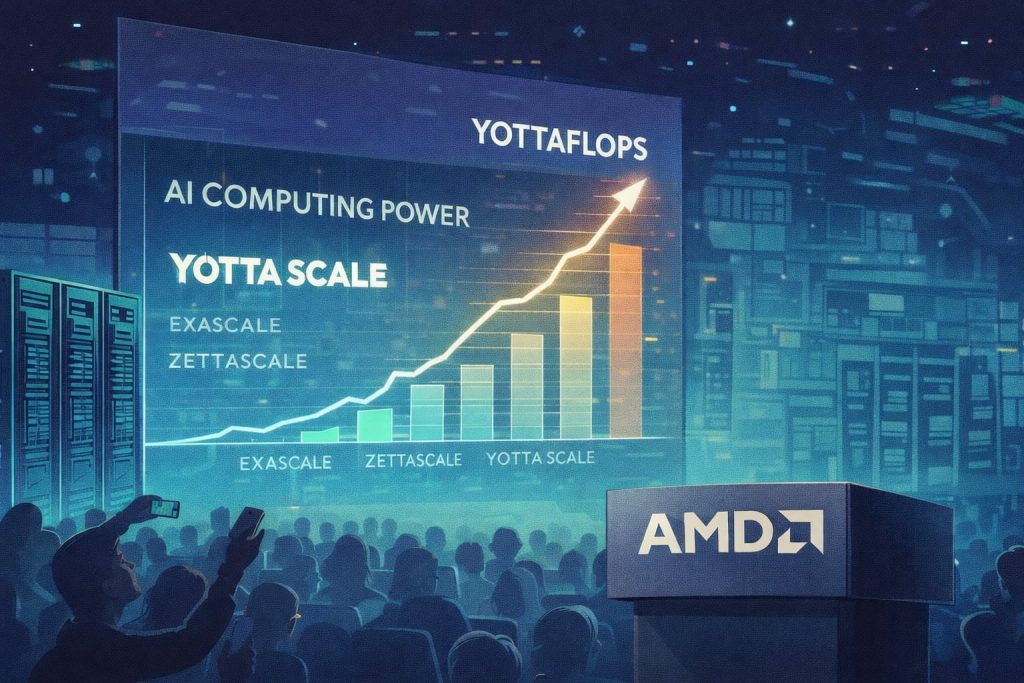

Industria tehnologică se află în pragul unei revoluții absolute, iar un termen precum „yottaflops” începe să devină mai mult decât un simplu buzzword. În realitate, acesta indică o etapă de scalare colosală a infrastructurii dedicate inteligenței artificiale, un semn clar că AI nu mai este doar o funcție de performanță, ci devine fundamentul pentru întregul ecosistem digital.

### Yottascale: Trecerea de la performanță la infrastructură

Până nu demult, termenii precum exascale sau zettaflops reprezentau niște standarde avansate de calcul, folosite în special pentru supercomputere. Acum, însă, anunțul AMD referitor la planurile pentru atingerea yottascale, stabilit pentru anul 2026, schimbă complet paradigma. Nu mai vorbim despre o simplă creștere a puterii de procesare, ci despre o schimbare de „regim” în centrul fațadei digitale, în care AI capătă o infrastructură proprie, un ecosistem în care miliarde de operații rulează constant pentru a satisface nevoile unei lumi digitale tot mai conectate.

Abordarea nu mai este despre tumultul construcției de clustere exascale, ci despre crearea unei rețele distribuite și eficiente, care să suporte milioane de operațiuni simultan, oriunde s-ar afla utilizatorul. Diferența esențială, explicată clar, fiind aceea că un yottaflop reprezintă 10^24 de operații pe secundă, adică un număr care depășește cu mult capacitatea oricărui supercomputer de ultimă generație. E ca și cum ai combina într-un singur ecosistem întregul univers al supercalculatoarelor exascale, iar această complexitate transformă AI-ul într-o infrastructură de sine stătătoare, nu doar o serie de modele distribuite.

### De la învățare la inferență: noul centru nevralgic al AI-ului

Inițial, dezvoltarea AI s-a concentrat pe antrenare, adică pe crearea modelelor gigant, pe seturi de date ample și sesiuni de training intensive. Dar, odată cu creșterea capacităților, disciplina a migrat spre inferență și execuție continuă, zone unde AI are nevoie de o infrastructură capabilă să funcționeze nonstop pentru a răspunde miliardelor de solicitări ale utilizatorilor.

Aceasta înseamnă că AI nu mai este un proces sporadic, ci un serviciu continuu, care trebuie să proceseze fluxuri de date în timp real și să răspundă instantaneu în multiple medii: text, voce, imagini, video sau semnale din senzori. În această schimbare de paradigmă, „cât de mare e modelul” a devenit un factor secundar comparativ cu frecvența și complexitatea cu care este utilizat, precum și cu capacitatea de a-l scala în funcție de necesități.

### Spațiul distribuit: soluția pentru scalare la yotta

Un aspect esențial în această aventură a scalării dincolo de exascale îl reprezintă distribuția AI-ului la nivel global. Niciun supercalculator din lume nu poate susține astfel de volume în mod eficient, mai ales într-un mediu în care latența, costurile și reziliența sunt priorități. În loc de a construi un singur supercomputer uriaș, soluția emergentă este aceea de a disemina sarcinile pe diverse centre de date, în rețele extinse și eficiente, de tip edge computing și dispozitive locale.

Astfel, AMD enfatizează importanța unui portofoliu tehnologic „full stack”, care să cuprindă de la cipuri puternice, la rețelistică avansată și software optimizat pentru distribuție. „Helios”, proiectul revoluționar în infrastructură AI, devine astfel un exemplu de viziune strategică pentru viitor, concentrată pe densitate, eficiență energetică și integrare completă între hardware și software.

Pe măsură ce tehnologia avansează, semnalele cele mai concrete pentru viitorul AI la nivel global vor fi reducerea costurilor pe unitate de inferență și posibilitatea distribuirii rapide și eficiente a sarcinilor între cloud, edge și dispozitivele locale. În această concurență tehnologică, yottaflops nu mai sunt doar un simbol al ambiției, ci un indicator clar al direcției în care se îndreaptă revoluția digitală.

Fii primul care comentează